Cloud-Services

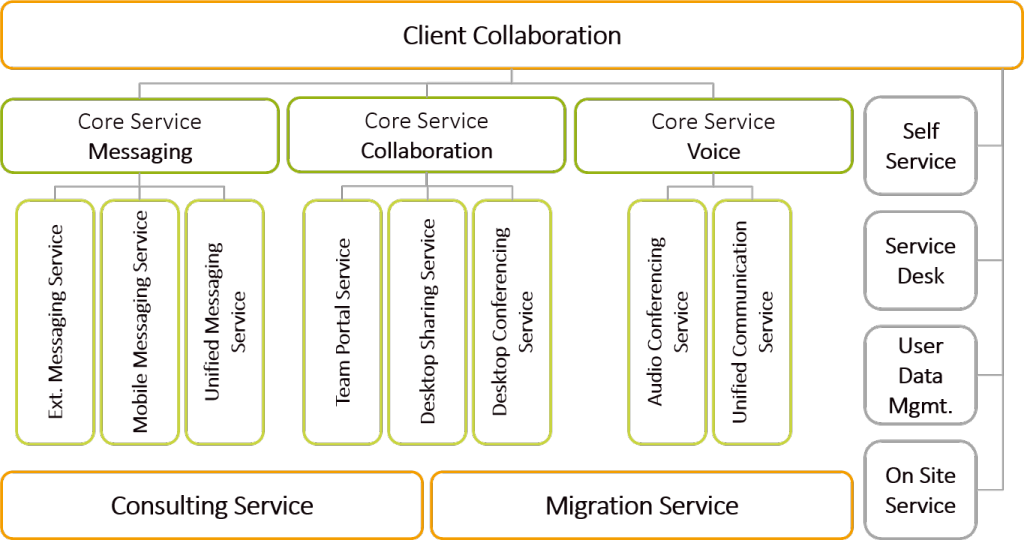

Eine wachsende Anzahl an Angeboten macht es deutlich, der IT-Markt sieht die Zukunft in Cloud-Services. Dienste aus der Cloud versprechen flexible Nutzung von IT-Ressourcen, ohne Vorabinvestitionen tätigen zu müssen. So passen sich sowohl die Leistung als auch die Kosten dynamisch an die individuellen Bedürfnisse der Kunden an. Mittlerweile haben sich drei Servicetypen mit unterschiedlicher Leistungstiefe herauskristallisiert. Am bekanntesten ist vermutlich das Software-as-a-Service (SaaS) bei dem der Kunde in der Lage ist, eine Fachapplikation plattformunabhängig zu nutzen. Hier werden beispielsweise Customer Relationship Systeme oder Collaboration Suiten in Anspruch genommen. Der Anbieter übernimmt hier alle notwendigen Aufgaben, die sich rund um den Applikationsbetrieb ergeben. Dazu stellt er neben der Anwendung auch die notwendige Infrastruktur zur Verfügung. Werden dagegen nur einfache IT-Ressourcen wie Speicher oder Rechenkapazität benötigt, so lassen sich diese über ein Infrastructure-as-a-Service (IaaS) Angebot nutzen. Irgendwo zwischen diesen beiden Leistungsbündeln befindet sich Plattform-as-a-Service (PaaS), bei dem komplette Entwicklungs- und Betriebsumgebungen nutzbar sind.

Einfach und dynamisch

Die Vorteile für die Nutzung von Cloudleistungen liegen auf der Hand. Der Kunde kann die Leistung sofort nutzen und alle betrieblichen Aufgaben an den Anbieter überwälzen. Dabei bezahlt er nur das, was er auch wirklich nutzt. Die Dienstleister können im Gegenzug die Auslastung ihrer Infrastruktur erhöhen und die Betriebskosten auf viele Kunden verteilen. Gleichzeitig sind sie in der Lage, ihren Absatzmarkt zu vergrößern. Regionale Lage und Größe der Kunden treten in den Hintergrund, so dass die Leistungen einem breiteren Kundenkreis angeboten werden können. Als Schnittstelle dient in der Regel eine Self-Service-Plattform, auf der der Kunde die Abwicklung seiner Leistungen selbst organisiert. Hier kann er das Leistungsvolumen und gegebenenfalls das Leistungsniveau überwachen und selbst an seine Bedürfnisse anpassen. Dadurch werden die Transaktionskosten, die bei der Anpassung und Abwicklung von Leistungen entstehen, auf beiden Seiten weiter reduziert. Jenseits dieser Plattform bleibt die Umsetzung der Leistungserbringung für den Kunden intransparent. Auf der einen Seite ist das auch ein erwünschter Effekt. Der Kunde möchte ja nur die Leistung nutzen, sich aber eben nicht um die Erbringungsdetails kümmern. Auf der anderen Seite ist der Kunde aber auch verpflichtet sicher zu stellen, dass er gesetzliche Vorgaben in Bezug auf Datensicherheit und Datenschutz einhält. Dies fällt ihm allerdings gerade wegen dieser Intransparenz schwer.

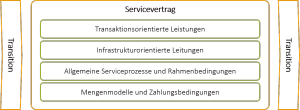

Was ist drin?

Grundsätzlich haben Anbieter und Kunde eigentlich recht unterschiedliche Interessen. Während der Kunde ein Höchstmaß an Leistung erwartet und dafür so wenig wie möglich ausgeben möchte, verhält es sich beim Anbieter genau umgekehrt. Dies ist in allen vertraglichen Situationen so und stellt normalerweise kein Problem dar. Der Kunde hat für ein definiertes Leistungsniveau eine gewisse Zahlungsbereitschaft. Im Gegenzug hat der Verkäufer einen Mindestpreis, den er erzielen muss. Ist die Zahlungsbereitschaft mindestens so hoch wie der Mindestpreis, so kann ein Geschäft zustande kommen. Vor dieser Situation stehen Mensch und Unternehmen täglich und meistern sie hervorragend. Voraussetzung hierfür ist, dass der Gegenstand der gekauft bzw. verkauft werden soll, beiden Parteien hinreichend bekannt ist. Die ist jedoch bei Cloud-Services gerade nicht der Fall. Für den Kunden sind die Art der Leistungserbringung, die Performanzreserven, die Vorsorgemaßnahmen und das Sicherheitsniveau intransparent. Um die Anforderungen an die Leistung entsprechend definieren zu können, muss sich der Kunde doch wieder mit der Art und Weise der Leistungserstellung auseinandersetzen. Eigentlich ein Thema, das er überwälzen wollte. Dies ist ein Grund, warum sich der Cloud-Markt wesentlich langsamer entwickelt als vorhergesagt.

Lock-In

Ein weiteres Hemmnis, das die Entwicklung des Cloud-Marktes bremst, ist der Lock-In-Effekt. Es ist zwar relativ einfach, in der Cloud loszulegen, hat man sich aber mal für einen Anbieter entschieden, so ist man auf diesen festgelegt. Gerade bei SaaS-Diensten werden proprietäre Datenmodelle verwendet, die sich technisch und strukturell kaum in andere Lösungen überführen lassen. Selbst wenn die Migration technisch machbar wäre, ist der Zugriff auf die Daten in der Regel beschränkt. Aus Sicht der Anbieter besteht auch kaum ein Grund, in eine leichtere Umzugsmöglichkeit ihrer Kunden zu investieren. Dies erhöht nur die Kosten und vergrößert die Gefahr, dass Kunden zur Konkurrenz wechseln.

Was tun?

Die Vorteile einer Cloud sind unübersehbar und der Siegeszug wohl schon lange nicht mehr aufzuhalten. Trotzdem müssen sowohl Dienstleister als auch Kunden einiges tun, damit sich der Markt und der Nutzen auf beiden Seiten noch besser entwickeln kann. Einige Aspekte wurden weiter oben schon angerissen. So sind die Kunden gefordert, ihre Bedürfnisse genauer zu fassen und passgenaue Angebote zu suchen. Dabei spielt das erwartete Nutzungsverhalten genauso eine Rolle wie Anforderungen an die Sicherheit und die Möglichkeit, zu einem anderen Anbieter umzuziehen. Für die Dienstleister wird es weiterhin wichtig sein, durch Transparenz an der Leistung und den Verrechnungsmodellen das Vertrauen der Kunden zu gewinnen und zu stärken.

Wie gehen Sie mit dem Thema um?

Diskutieren Sie mit:

Business Excellence Forum: Cloud Management

Am 22.10.2015 in München und am 19.11.2015 In Frankfurt am Main.

Das kostenlose Business Excellence Forum ist für interne und externe IT-Dienstleister und ihre Kunden, die im Rahmen von Expertenrunden erfahren möchten, wie das Management von Services, deren Sicherheit und Risiken nachhaltig verbessert werden können. Erfahrene Referenten berichten über neue Erkenntnisse, ihre Herausforderungen in der Praxis und erläutern praktikable Lösungen. Im Anschluss werden die Erfahrungen aller Teilnehmer im Plenum und im Rahmen eines Business Lunches in lockerer Atmosphäre diskutiert. Eine perfekte Gelegenheit für alle die neue Blickwinkel erkennen und Kontakte aus der Branche knüpfen möchten.